El Partido Republicano de la Cámara de Representantes con el proyecto de ley de recortes de impuestos de Trump, pero un nuevo informe dice que se sumará al déficit

mayo 21, 2025

124 países miembros de la OMS firman Acuerdo de Pandemias, un tratado histórico que prepara al mundo para la siguiente crisis sanitaria

mayo 21, 2025Green estaba atravesando una ruptura. Las razones habían sido poco destacables para los estándares de una ruptura: dos personas, incapaces de satisfacer las necesidades de la otra y con dificultades para comunicarse, habían decidido que lo mejor era separarse. Así que, cuando su ex se puso en contacto sin avisar, Green se sorprendió.

El correo electrónico en sí no era notable. Green, una persona neoyorquina de 29 años, lo describe como la típica carta que se recibe tras una ruptura, una exposición de agravios en la que se señalan las formas en que no se cumplieron las expectativas. Aun así, ambos debían abstenerse de ponerse en contacto. A Green no le gustó el mensaje ni su tono, y se lo hizo saber a su ex.

«La respuesta que recibí fue que habían hecho todo lo posible para asegurarse de que no era ofensivo ni mezquino, que lo habían pasado varias veces por ChatGPT para asegurarse de que no hería los sentimientos de nadie. ChatGPT no tiene la historia de pareja que yo tengo, así que no sé cómo podría aplicar el contexto de nuestra relación», refiere Green.

Green, un usuario de ChatGPT que de vez en cuando también resuelve sus problemas con la plataforma, se quedó perplejo al principio, y luego se enfadó. «Me sorprendió que una relación tan personal y afectuosa se redujera a la opinión de ChatGPT, frente a mis propios límites, opiniones o necesidades. Me sentí impersonal».

Los usuarios están utilizando el nuevo generador de imágenes de OpenAI para formar parte de las tendencias virales de redes sociales. Pero su uso pone en riesgo la privacidad, a menos que se tomen unas sencillas medidas de contención.

ChatGPT, necesito tu opinión más sincera…

La IA generativa se ha infiltrado rápidamente en todos los aspectos de la vida moderna. Ha penetrado en puestos de trabajo de muchas industrias diferentes, ha canibalizado el arte original y ha robado a los creadores para hacer de las suyas. Los estudiantes la utilizan para hacer trampas, los profesores para planificar sus clases. Está radicalizando a usuarios vulnerables. Pronto podría ayudar a dictar la aprobación de nuevos medicamentos. Afecta profundamente a nuestro medio ambiente. La IA reanima a las víctimas tras su muerte para que declaren ante los tribunales. La gente se enamora del chatbot de OpenAI. Otros la utilizan como terapia.

Inevitablemente, parece que la IA se ha convertido en la herramienta que la gente utiliza ahora en lo más humano de todo: el intento de entenderse. Ya sea analizando textos de posibles parejas para discernir significados subyacentes, resolviendo disputas con amigos o intentando hacer las paces con la familia, la gente recurre a ChatGPT para resolver sus problemas interpersonales, a solas. Además de su sincero deseo de comunicarse mejor con los demás, los usuarios de ChatGPT con los que habló WIRED siguen sintiéndose avergonzados de utilizar una computadora para resolver problemas muy humanos. Todos ellos pidieron que no se utilizaran sus apellidos por motivos de privacidad.

Descargar el trabajo emocional a la IA en lugar de a otra persona conlleva un riesgo. «Nuestras amistades dependen de esos vínculos. Tenemos que ser conscientes de cuáles son los ingredientes ancestrales de una sociedad humana que funcione, de una amistad humana que funcione», afirma Daniel Kimmel, psiquiatra clínico de la Universidad de Columbia. Los humanos hemos pasado cientos de miles de años desarrollando nuestro propio «simulador emocional», instintos que nos ayudan a entendernos, añade Kimmel. La IA no tiene esa experiencia emocional. Lo que sí tiene es «un motor predictivo extremadamente potente» que puede interpretar patrones y lenguaje.

«Ahí radica la limitación de la IA: solo puede funcionar con palabras. Nuestro modelo se basa en algo que no son palabras. Es inefable», refiere Kimmel.

Los usuarios se quejan de una nueva tendencia de «adulación» donde ChatGPT piensa que todo es brillante y genial.

De un uso superficial a uno íntimo

Kate, una mujer de 35 años que vive en Denver, lleva dos meses y medio utilizando ChatGPT para analizar sus relaciones. Comenzó a usar el chatbot en su trabajo, donde su equipo utiliza el servicio en sus propios proyectos y asesora a las empresas sobre cómo integrarlo en los suyos.

Para Kate, no fue difícil dar el salto del uso profesional al personal de ChatGPT. En la época anterior a la IA, ya estaba acostumbrada a leer hilos de Reddit o a buscar en Google preguntas sobre relaciones del tipo «cómo saber si el chico con el que sales ha superado a su ex». Kate dice que las heridas de relaciones pasadas siguen afectando a su comportamiento y sus emociones. «Tengo un claro estilo de apego ansioso, que se ha manifestado cuando estoy en las primeras etapas de una relación».

Al mes y medio de empezar a salir con alguien nuevo, Kate se encontró en un ciclo especialmente ansioso. El chico con el que salía se acababa de divorciar y tenía un hijo pequeño, lo que le provocaba asociaciones dolorosas con su ex y le preocupaba volver a salir herida. Ella y el chico tenían un largo historial de mensajes de texto, así que Kate exportó todos sus chats y los cargó en ChatGPT. «Le pedí que analizara nuestros intercambios de mensajes y me diera una puntuación». Incluía preguntas como sus respectivos estilos de apego, los aspectos saludables de sus relaciones y, quizá, la más aterradora de todas: ¿A quién le gusta más quién?

«Me lo tomé muy mal, la verdad», recuerda sobre las respuestas que recibió. ChatGPT le dijo que su actual pareja se inclinaba hacia un estilo de apego evitativo, del que quería mantenerse alejada. «Pero fue muy esclarecedor. De hecho, lo compartí con mis amigas». Para Kate, era reconfortante tener toda la relación al descubierto. «Me tranquilizó en ese momento, porque si mi cabeza o mis pensamientos se escapan, era increíble tener una especie de tercera persona que pudiera experimentar rápidamente las cosas desde mi perspectiva».

Kate explica que se sentiría halagada si la situación fuera al revés. «Si te soy sincera, me sentiría honrada de que me tuvieras tan en cuenta como para que pidieras que ChatGPT hablara de mí. Me gustaría saber qué dice ChatGPT y luego valorar cómo me siento».

Aun así, confiesa: «También me rompería el corazón».

ChatGPT tiene ahora tanta información sobre su relación actual almacenada en su memoria que lo utiliza «como su terapeuta». También puede provocar ansiedad; ChatGPT puede ofrecer una hipótesis sobre el comportamiento de su pareja que sugiera que se está alejando, cuando en realidad solo está ocupado en el trabajo. A veces puede pasarse horas introduciendo mensajes sobre sus relaciones. «No digo que siempre sea lo más sano», argumenta.

La terapeuta de Kate en la vida real no es fan de su uso de ChatGPT: «Kate, prométeme que no volverás a hacerlo. Lo último que necesitas son más herramientas de análisis a tu alcance. Lo que necesitas es sentarte con tu malestar, sentirlo, reconocer por qué lo sientes».

La Ley de Retirada de Contenidos exige a las plataformas que retiren los casos de «representación visual íntima» en un plazo de dos días. Según los defensores de la libertad de expresión, esta podría ser un arma para alimentar la censura.

Repitamos, ChatGPT no es un terapeuta certificado

Una portavoz de OpenAI, Taya Christianson, indicó a WIRED que ChatGPT está diseñado para ser una herramienta de uso general, neutral y orientada a la seguridad. Según Christianson, no sustituye a la consulta con un profesional de la salud mental. Christianson remitió a WIRED a una entrada de blog en la que se cita una colaboración entre la empresa y el MIT Media Lab para estudiar «cómo el uso de la IA que implica un compromiso emocional, lo que llamamos uso afectivo, puede repercutir en el bienestar de los usuarios».

Para Kate, ChatGPT es una caja de resonancia sin necesidades, horarios, obligaciones ni problemas propios. Tiene buenos amigos y una hermana con la que está muy unida, pero no es lo mismo. «Si les mandara tantos mensajes como los que les envío a ChatGPT, les reventaría el teléfono. No sería justo. No necesito sentir vergüenza por llenar a ChatGPT con mis peticiones, mis necesidades emocionales».

Andrew, un hombre de 36 años que vive en Seattle, ha recurrido cada vez más a ChatGPT para sus necesidades personales tras un duro capítulo con su familia. Aunque no trata su uso de ChatGPT «como un sucio secreto», tampoco es especialmente comunicativo al respecto. «No he tenido mucho éxito a la hora de encontrar un terapeuta con el que congeniar. Y no es que ChatGPT sea, ni mucho menos, un verdadero sustituto de un terapeuta, pero para ser totalmente honesto, a veces solo necesitas a alguien con quien hablar de algo que tienes en la cabeza».

Andrew ya había utilizado ChatGPT para tareas mundanas como planificar comidas o resúmenes de libros. El día antes de San Valentín, su novia de entonces rompió con él por mensaje de texto. Al principio, no estaba del todo seguro de que le hubieran dejado. El mensaje rezaba: «Creo que entre nosotros siempre hubo una especie de desconexión en la forma de comunicarnos». En realidad no decía: «Oye, estoy rompiendo contigo». Desconcertado, introdujo el mensaje en ChatGPT. «Me preguntaba si había roto conmigo. ¿Puedes ayudarme a entender qué está pasando?». ChatGPT no aclaró mucho las cosas. «Supongo que tal vez me validó, porque estaba tan confundido como yo».

Andrew tiene chats de grupo con amigos íntimos a los que normalmente acudiría para hablar de sus problemas, pero no quería agobiarles. «Quizá no necesiten oír las quejas de Andrew sobre su horrible vida sentimental. Estoy usando esto como una forma de tantear el terreno de la conversación antes de prepararme realmente para salir y preguntar a mis amigos sobre una determinada situación».

Además de las complejidades emocionales y sociales de resolver problemas a través de la IA, el nivel de información íntima que algunos usuarios proporcionan a ChatGPT plantea serios problemas de privacidad. Si alguna vez se filtran los chats, o si los datos de los usuarios se utilizan de forma poco ética, hay algo más que contraseñas o correos electrónicos en juego.

«Sinceramente, he pensado en ello. Dios mío, si alguien viera mi historial de mensajes, podría hacer suposiciones descabelladas sobre quién eres, qué te preocupa o cualquier otra cosa», comenta Kate cuando se le pregunta por qué confía al servicio detalles privados de su vida.

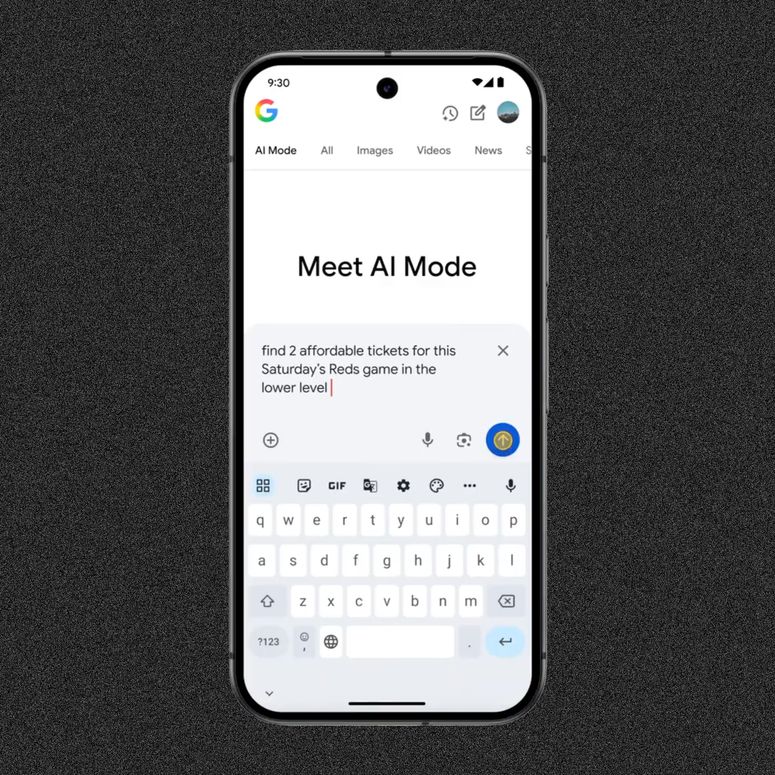

La nueva experiencia de Google, que hasta ahora era un experimento, se lanza para los usuarios estadounidenses. Los editores y vendedores tendrán que ajustar sus estrategias de búsqueda una vez más.

¿Un paso antes de que acudas a terapia?

Christianson explicó a WIRED que el modelo de ChatGPT pretende ofrecer ayuda y, al mismo tiempo, orientar a los usuarios hacia ayuda profesional y contactos en el mundo real. La empresa ya ha dicho que está «comprometida con la protección de la privacidad de las personas». El servicio incluye ajustes de privacidad que los usuarios pueden modificar para decidir cuántos de sus datos se utilizan para entrenar los modelos de ChatGPT, pero inevitablemente ingiere enormes cantidades de datos personales. Las personas con las que habló WIRED han demostrado un alto nivel de confianza en OpenAI con lo que se ha convertido esencialmente, para ellos, en un diario de alto funcionamiento.

Andrew describe su nivel de confianza como un «esperanzador apretón de manos» con ChatGPT.

«Probablemente suene muy triste, pero a veces me resulta más fácil confiar en una plataforma tecnológica», afirma. Ha vivido situaciones en las que personas de su vida convertían sus confesiones privadas en moneda de cambio conversacional. En comparación, ChatGPT es más una caja cerrada, una parte neutral a la que no le interesa el chismorreo.

Las reservas sobre el uso de ChatGPT como diario o intermediario parecen estar disminuyendo. En TikTok, los creadores de contenido están enseñando a los usuarios a utilizar la IA para analizar discusiones de texto, obtener consejos sobre relaciones y responder automáticamente a citas o rupturas. A Kate estos videos le resultan útiles para encontrar nuevas ideas.

Recientemente, vio una propuesta en TikTok en la que un usuario puede describir sus objetivos y lo que le gustaría lograr, y luego pedir a ChatGPT que escriba una historia con todo lujo de detalles de cómo podría ser esa vida. «Te ayuda a encarnarlo o experimentarlo, a vivir cómo podría ser».

«La cantidad de veces que lo he utilizado ha crecido exponencialmente», concluye Kate. Aun así, ahora intenta utilizarlo un poco menos en su vida sentimental, tal y como le recomendó su terapeuta de carne y hueso.

Artículo originalmente publicado en WIRED. Adaptado por Alondra Flores.